Processing of satellite images in order to determine floodplain areas in Florencio Varela and surrounding areas

Ing. Alicia Szymanowski[1]: (UNAJ)

Resumen

En este proyecto, se ha trabajado en un área de investigación y desarrollo bastante novedosa, que consiste en la caracterización de zonas mediante el uso de imágenes satelitales. Si bien se venían adquiriendo imágenes desde satélites desde hace un tiempo en el espectro visible, en este momento, la tecnología amplió y se adquieren señales en banda C, X, L, etc. mediante radiómetros instalados en los satélites, que luego de procesarse, dan lugar a productos que son de gran importancia para el desarrollo del país.

El primer paso ha sido la adquisición de las imágenes, estas tienen orígenes en distintos satélites. Luego sigue una etapa de manipulación de la imagen, aplicando distintos algoritmos para mejorarla, y acondicionarla de modo que el resultado sea el más adecuado para la aplicación específica. Posteriormente, viene un proceso llamado segmentación, que lleva un largo camino hacia la solución exitosa, sobre todo si requerimos que el sistema reconozca el elemento buscado, ya sea agua, incendios, embarcaciones, determinado tipo de cultivos, etc.

Las imágenes satelitales trabajadas tienen un peso de 4 GB, y con cada procesamiento que se realiza sobre ellas, se trabaja con submatrices para formar nuevas imágenes. De modo que se necesita gran capacidad de procesamiento y de almacenamiento. Por ello, se había comenzado a armar un cluster de computadoras orientado a ésta aplicación científica, se esperaba que cumpliera con requisitos de alto rendimiento, alta disponibilidad, balanceo de carga y escalabilidad, pero no pudo llegarse al fin de este objetivo debido a la pandemia del Covid-19.

Palabras claves: teledetección, Procesamiento de imágenes, Radar

Abstract

In this project, we have been working in a rather novel area of research and development, which consists in the characterization of areas by using satellite images. Although images have been acquired from satellites in the visible spectrum for a while, at this time, the technology expanded and signals in band C, X, L, etc. can be acquired by radiometers installed in the satellites. After being processed, they produce important products for the development of the country.

The first step has been the acquisition of the images, originated in different satellites. The following stage is manipulating the image, applying different algorithms to improve it, and condition it so the result is the most suitable for the specific application. Subsequently, comes a process called segmentation, which goes a long way towards a successful solution, especially if we require the system to recognize the desired element, be it water, fire, boats, certain types of crops, etc.

The satellite images which we have worked with have a weight of 4 GB, and in each procedure that is carried out on them, submatrices are worked on to form new images. Therefore, you need a lot of capacity to process and storage. For this reason, a computer cluster oriented to this scientific application had begun to be assembled. It was expected to meet the requirements of high performance, high availability, load balancing and scalability, but the objective could not be reached due to the Covid-19 pandemic.

Keywords: teledetection, Image processing, Radar

Introducción

El objeto de la investigación trata un tema de gran importancia para nuestro país que, involucrando a universidades y a empresas argentinas, en los últimos años está poniendo en órbita varios satélites desarrollados y fabricados aquí mismo, como lo son el Satélite de Aplicaciones Científicas (SAC-C), el Satélite de Observación Climática y Oceanográfica (SAC-D/Aquarius) y el Satélite de Observación con Microondas (SAOCOM 1A y 1B) de la Comisión Nacional de Actividades Espaciales (CONAE), además de los satélites de comunicaciones ARSAT 1 y 2 de ARSAT para la mejora de las telecomunicaciones.

El SAOCOM es casi único en su tipo en el mundo: cuenta con una gran antena (de 35 metros cuadrados), que posee un radar de apertura sintética (SAR) en banda L. El SAOCOM 1B fue lanzado el año 2020 desde cabo Cañaveral por la Comisión Nacional de Actividades Espaciales (CONAE) y es igual al 1A, lanzado en el año 2018 y, junto con el “Advanced Land Observation Satellite” (ALOS), de Japón, son los únicos satélites en el mundo que tienen este tipo de antena radar. Se trata de satélites que dan la vuelta al mundo cada una hora y media, y que son capaces de detectar el nivel de humedad del suelo, la vegetación, y objetos de la superficie de la Tierra ubicados hasta dos metros de profundidad, dependiendo de los materiales detectados.

Los SAOCOM forman parte de la constelación del Sistema Italo Argentino de Satélites para la Gestión de Emergencias (SIASGE) que, en conjunto con los satélites Cosmo SkyMed de Italia, dan información para la gestión de emergencias. Mientras los satélites están recorriendo otros puntos de la Tierra que no demandan información, quedan capacidades ociosas que pueden ser comercializadas, generando así una exportación de alto valor agregado que permitiría el ingreso de divisas al país.

La CONAE tiene la misión de proponer y ejecutar el Plan Espacial Nacional, que se establece como una clara política de Estado de prioridad nacional y se concreta a través de tres componentes: la observación de la Tierra, la exploración y utilización pacífica del espacio ultraterrestre y el desarrollo de tecnologías para uso espacial. Por ello es importante la formación de ingenieros que tengan una perspectiva de trabajo en este sentido, ya sea para desarrollarse en la universidad o en el ámbito privado.

Para este trabajo se partió de dos objetivos generales: desarrollar e implementar algoritmos para el procesamiento de imágenes de sensoramiento remoto para el monitoreo de inundaciones en la zona de Florencio Varela y zonas aledañas; y el armado de un clúster para el procesamiento de las imágenes satelitales, este último desarrollo se vuelve necesario cuando se quieren entrecruzar imágenes para aplicar los algoritmos.

La información que obtenemos con los datos de medición y observación a distancia nos permite tomar las decisiones adecuadas para llevar a cabo distintas actividades, como las relacionadas con la economía, la ecología, la seguridad y la salud.

En teledetección óptica lo que se mide es la radiancia espectral que posteriormente es transformada en valores de reflectividad. Debido a que las imágenes en el visible son producto de la luz (radiación) solar reflejada, solo se pueden obtener durante las horas del día. Las nubes, la atmósfera y la superficie terrestre, absorben y reflejan la radiación solar incidente. Cuando cae la noche, el canal visible deja de ser útil en ese lugar.

Las ventajas de la teledetección radar frente a la óptica es que aquella funciona frente a cualquier situación meteorológica, permitiendo tomar datos tanto de día como de noche, penetrando en la vegetación y en los suelos, y además es sensible frente a las propiedades dieléctricas de la superficie. Por ejemplo, distingue hielo de agua líquida.

Entre las desventajas de la teledetección radar frente a la óptica, encontramos que a veces las imágenes obtenidas son difíciles de interpretar por la presencia de ruido (speckle), o en áreas con topografías contrastadas que deben ser corregidas.

Desde hace tiempo se trabaja con imágenes satelitales en el espectro visible, que parecen fotografías en blanco y negro, las nubes suelen ser blancas, mientras que las superficies del suelo y del agua son negras o de tonos grises; los desiertos y la vegetación (bosques) se pueden distinguir por sus distintos tonos de gris: los desiertos presentan tonos más claros y la vegetación, más oscuros; las superficies de agua suelen ser más oscuras que el suelo adyacente. Las aguas costeras se distinguen de las tierras costeras, que son de un tono gris más claro. Las imágenes en el visible incluso permiten ver el humo de los incendios forestales.

Para este trabajo, se optó por las imágenes de radar, ya que son producto de una tecnología desarrollada en el último tiempo y que tienen la gran ventaja de que las imágenes son transparentes a la nubosidad del momento en que se toman.

Un sistema de radar o radiómetro activo de microondas es un instrumento que mide distancias y que trabaja en regiones del espectro electromagnético con longitudes de onda que van desde 0,1 cm a 1 m. Consiste en un transmisor de pulsos de microondas y en una antena que recibe una proporción de la energía retro-dispersada, mide el tiempo que tarda la señal en regresar al sensor y de esta manera se determina la distancia que recorrieron los pulsos. Los radares miden la amplitud y la fase, la amplitud es la intensidad de la señal retro-dispersada que vuelve a la antena y se normaliza respecto al área, normalmente se expresa en dB. La fase corresponde a la posición de un punto en el tiempo, la diferencia de fase entre dos imágenes capturadas en dos fechas diferentes sobre la misma zona se denomina interferograma.

La potencia recibida en el radar es aproximadamente:

![]()

Depende de la potencia transmitida, de las ganancias de las antenas transmisora y receptora, de la longitud de onda, de sigma que es la reflectividad del blanco y también se conoce como coeficiente de retro-dispersión, de las pérdidas del espacio libre, pero como la onda va y vuelve, la distancia entre el emisor y el blanco queda elevada a la cuarta potencia, llegamos así a la siguiente fórmula:

![]()

Pero un pixel puede estar compuesto por varios blancos, y cada uno va a contribuir de alguna manera a la potencia que vuelve al radar. Si la zona que estamos mirando con un pixel se agranda, lo más probable es que abarque más blancos, por ello se define 0 que es el coeficiente de retro‑dispersión normalizado donde:

![]()

Y a su vez 0 se trabaja en dB, es decir

Hay tres características que afectan a la señal retro-dispersada en cuanto a su interacción con el blanco: la longitud de onda, la polarización y el ángulo de incidencia.

La longitud de onda, o distancia entre crestas de la onda electromagnética, define la interacción de la señal con la superficie, mientras más larga la longitud de onda, mayor es la penetración en el medio. Si un objeto es aproximadamente del mismo tamaño de la longitud de onda aparecerá una interacción, por lo que se facilita su observación.

La banda X con ≈ de 2,5 cm a 3,75 cm, es útil para observar objetos de pequeñas dimensiones como diferentes tipos de nieve.

La banda L con ≈ de 15 cm a 30 cm, es útil para observar objetos de grandes dimensiones, como ramas de árboles o estructuras superficiales.

La banda P con ≈ 70 cm, es útil para observar estructuras geológicas.

La banda C, con ≈ de 7,5 cm a 37,5 cm es útil para cualquier tipo de aplicaciones.

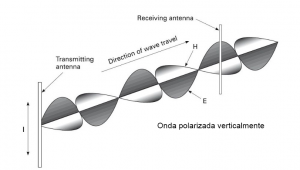

Figura 1

La polarización de la onda se refiere al plano de propagación del Campo Eléctrico de la señal. Existen dos polarizaciones base que son ortogonales entre sí, horizontal H y vertical V, en la figura 1 se ve una onda polarizada verticalmente. Entonces, el sistema puede emitir ondas polarizadas en horizontal o en vertical y recibir en cualquiera de las dos polarizaciones, por ejemplo, HH significa que emite y recibe en horizontal, HV significa que emite en horizontal y recibe en vertical. La polarización múltiple HH, HV, VV, VH, o también denominada Quad-Pol, ayuda a identificar la estructura física de las superficies reflectoras con mayor precisión que los sistemas de polarización HH, HV o VV, VH, también denominadas Dual‑Pol.

El radar se encuentra en un satélite, que, a medida que se mueve a lo largo de su dirección de vuelo, llamada azimut, genera una huella, swath, a lo largo de la superficie del suelo. El haz de la antena está orientado con cierta inclinación respecto al suelo, perpendicular a la dirección de vuelo, definiendo así el range. La resolución en range del radar se define como la mínima separación entre dos puntos en el range que el radar es capaz de separar y distinguir. Por lo tanto, la resolución en range δr depende de la duración del pulso radar tp o, de la inversa del ancho de banda B de la señal:

![]()

c es la velocidad de propagación de las ondas electromagnéticas o velocidad de la luz, y el factor 2 proviene del número de caminos que recorre la onda, ida y vuelta.

Para lograr una buena relación SNR con tiempos p cortos se emplean técnicas de compresión de pulsos, que se basan en pulsos modulados de larga duración con dos objetivos: lograr gran radiación de energía y conseguir resolución en range. Esto se logra modulando en frecuencia o en fase para ensanchar el ancho de banda B de la señal. El pulso recibido se procesa en un filtro adaptado, comprimiéndolo a una duración 1/B. Todos los sistemas de radar distinguen los blancos en range de la misma forma. Pero para la resolución en azimut, los blancos se distinguen de otra forma. El haz de la antena tiene un ancho angular a proporcional a la longitud de onda e inversamente proporcional a la longitud de la antena en azimut Da:

![]()

La resolución en la dimensión azimut está dada por la siguiente fórmula:

![]()

Donde r0 representa la distancia range entre la antena y el blanco. Para conseguir resoluciones altas se debería conseguir antenas demasiado grandes. Entonces, para mejorarla se creó el radar de apertura sintética (SAR), que aprovecha el movimiento del satélite en azimut para lograr antenas de longitud efectiva mucho mayor. De esta forma, el ancho del haz correspondiente a la longitud efectiva de una antena de apertura sintética Le en azimut, a una distancia range r0 es:

![]()

Aparece el factor dos, ocasionado por el desfase originado por la distancia recorrida por la onda ida y vuelta, entre la antena y el blanco. La resolución en azimuth a que se puede alcanzar es:

![]()

La longitud efectiva Le de la antena de apertura sintética, para un blanco a una distancia range r0, está limitada por el tiempo que el haz de radar ilumina el blanco. La longitud efectiva se puede calcular como:

![]()

Entonces, podemos calcular la máxima resolución en azimut da que se alcanza con un radar de apertura sintética:

![]()

O sea que, la resolución en azimut ya no depende ni de la longitud de onda, ni de la posición range r0 del blanco. Solo depende de la dimensión de la antena en azimut Da, de tal manera que, cuanto menor es la dimensión de la antena, mejor es la resolución. Este resultado se basa en el hecho de que la longitud de la antena efectiva es mayor para blancos lejanos que para cercanos.

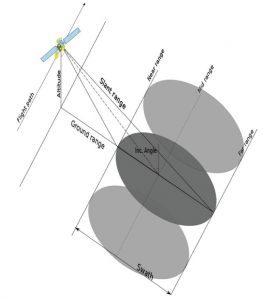

Figura 2

A diferencia de la teledetección óptica donde la observación es nadiral, es decir, hacia abajo; la observación en los sensores radares es lateral, por ello los pixeles de las imágenes tienen, como recién vimos, diferente resolución, en la dirección del azimuth que en la del alcance (Figura 2). Además, esta observación lateral provoca distorsiones que deben corregirse. Otro importante ítem a observar es el sentido en que captura las imágenes el satélite en su órbita, ascendente o descendente, y la configuración del relieve, ya que se producen distorsiones geométricas que desfiguran las formas, debido a los ecos que llegan a la antena, en forma inversa a su posición de acuerdo a la trayectoria, por ello se corrigen las imágenes de acuerdo a un modelo digital del terreno.

El otro problema de los sensores de radar es el speckle (ruido de sal y pimienta) que aparece como consecuencia de las interferencias que se producen en las distintas vistas de una misma superficie que se requieren con la tecnología SAR. Existen numerosas técnicas que tienen por objeto eliminar la influencia del speckle en las imágenes adquiridas mediante sistemas SAR. La más básica de todas ellas se conoce como multi-look, que consiste en el promediado de la imagen mediante una ventana, a menudo rectangular, y que se corresponde con el estimador de máxima verosimilitud. Sin embargo, el factor de reducción de speckle es proporcional al número de muestras promediadas e inversamente proporcionales a la resolución, por lo que se observa que existe un compromiso entre ambos. No es, por tanto, la mejor manera de afrontar el problema, puesto que reducir el speckle a costa de la resolución no tiene demasiado sentido en el caso de los sistemas SAR, cuya principal ventaja consiste precisamente en la elevada resolución que son capaces de proporcionar.

A pesar de los problemas geométrico y radiométrico, esta tecnología ha tenido un fuerte desarrollo es este último tiempo, pues proporciona información de gran utilidad para muchas aplicaciones. Por ejemplo, dar cuenta de la evolución de los casquetes polares, incluso monitorizar el rumbo de icebergs para alertar a naves que se encuentren navegando en la zona, monitorizar el desplazamiento de glaciares, vigilancia de embarcaciones en el mar, ver la contaminación del océano, como también, en el ámbito de las emergencias, se pueden observar las áreas afectadas por inundaciones.

La técnica de procesamiento de imágenes con combinación de bandas RGB (sigla que corresponde a las iniciales en inglés de los nombres de los colores Red, Green y Blue, es decir, rojo, verde y azul) brinda una solución simple y de enorme eficacia a la hora de consolidar los datos de distintos canales espectrales en imágenes realzadas capaces de comunicar más información que cualquier imagen individual.

Los realces RGB se utilizan ya hace bastante tiempo, en el ámbito de formación y en campos aplicados, como la gestión del suelo. El satélite LANDSAT, dedicado al estudio de los recursos terrestres, se utiliza para estudiar la cubierta del suelo, la vegetación y los recursos hídricos desde ya hace 50 años. El modelo RGB, como ya mencionamos, utiliza tres colores primarios: el rojo, el verde y el azul, que se pueden combinar de distintas maneras para generar una amplia gama de colores, desde los colores secundarios (amarillo, magenta, cian), hasta los grises, el negro y el blanco.

El procesamiento de imágenes con realces RGB admite canales de todo el espectro electromagnético, desde el visible e infrarrojo, hasta las microondas detectadas con métodos pasivos. Por eso los realces RGB se denominan multiespectrales: porque combinan la información de diferentes longitudes de onda y varias regiones del espectro electromagnético.

Metodología:

Se plantea el desarrollo de una metodología de índole práctica y teórica. Por tratarse de un tema que no se había visto en el desarrollo de la carrera, y siendo alumnos de los primeros años, por un lado, era importante conocer los fundamentos teóricos involucrados tanto en la adquisición de imágenes, como en su posterior tratamiento. Si bien se trabajó con software específico, es importante conocer que es los que se está llevando a cabo. Se trató de crear variadas técnicas de análisis teórico y simulación, experimentando y modelizando en base a observaciones de fechas, volviendo hacia atrás e invirtiendo pasos, de modo de llegar a la secuencia correcta. Fue necesario, realizar cursos para sortear inconvenientes que se presentaron, cuya solución requería procedimientos que no surgieron a simple vista.

Se trató de tomar como principio metodológico una orientación crítico – progresista (Barraza Macías, 2010), que se implementa dando lugar al desarrollo de las siguientes ideas: trabajo en grupo dando espacio al diálogo y a la colaboración como recursos centrales para la construcción de medios y fines deseables para la educación, analizando, discutiendo, argumentando y reflexionando sobre las prácticas y promoviendo el desarrollo de competencias que permitan la problematización y la solución creativa de problemas.

Por otro lado, se tratará de hacer una reflexión en relación con diferentes aspectos de la práctica en el marco de la “investigación acción” tomando una postura exploratoria frente a distintas situaciones

que se fueron presentando desde el punto de vista de quienes actúan e interactúan en la situación-problema.

Resultados:

En principio se trató de buscar algunas imágenes de radar y estudiar cómo llegar a su procesamiento.

Nuestra zona de estudio es Florencio Varela y zonas aledañas (Figura 3).

Figura 3

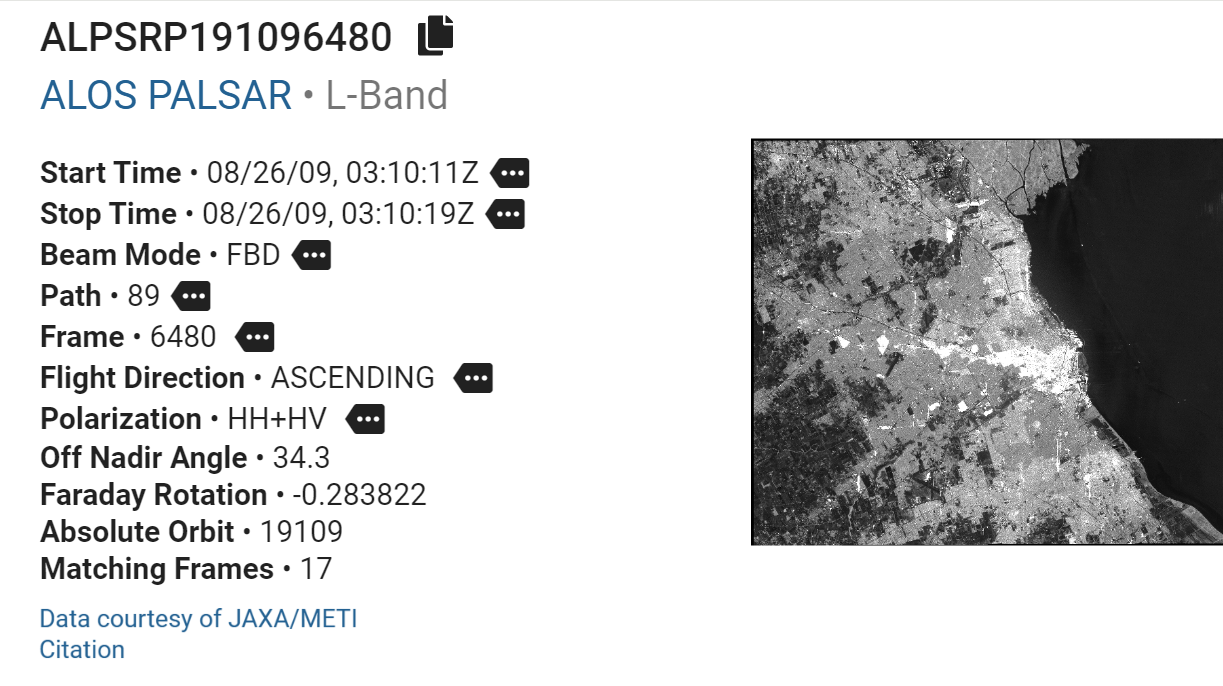

Comenzamos trabajando con una imagen de ALOS como podemos observar en la figura 4:

Figura 4

Se trata de una imagen de radar, del Dataset de datos de ALOS PALSAR del 26 de agosto del año 2009, esta imagen contiene la polarización HH+HV. En la figura 5 podemos ver la imagen sin ningún procesamiento:

Figura 5

Esta imagen requiere de una calibración ya que se encuentra comprimida horizontalmente. Al hacer este procesamiento obtenemos (Figura 6):

ALOS-H1_1__A-ORBIT__ALPSRT269136480_Cal

Figura 6

Para disminuir el ruido speckle en la imagen se utiliza un proceso de multilook, generando una nueva imagen. Al hacer este procesamiento obtenemos (Figura 7):

ALOS-H1_1__A-ORBIT__ALPSRT269136480_Cal_ML

Figura 7

En las imágenes del ALOS PALSAR I es necesario aplicar un proceso de deskewing antes de proyectarla en el terreno, encontrando así otro producto. Al hacer este procesamiento obtenemos (Figura 8):

ALOS-H1_1__A-ORBIT__ALPSRT269136480_Cal_ML_DSk

Figura 8

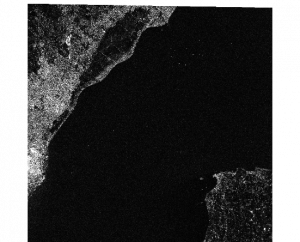

Por último, se proyecta la imagen del slant range al ground range. Se puede proyectar la imagen sobre el elipsoide o sobre un modelo de elevación digital. Al hacer este procesamiento obtenemos (Figura 9):

ALOS‑H1_1__A‑ORBIT__ALPSRT

269136480_Cal_ML_DSk_EC

Figura 9

Para facilitar la exploración de las imágenes, conviene trabajarlas en dB pues resulta más natural a nuestra vista, obteniendo un nuevo producto (Figura 10):

ALOS-H1_1__A‑ORBIT__ALPSRT

269136480_Cal_ML_DSk_EC_dB

Figura 10

En lugar de proyectarla sobre la elipsoide, se puede proyectar sobre un modelo de elevación digital DEM, que se descarga automáticamente. Obtenemos así un nuevo producto (Figura 11):

ALOS-H1_1__A-ORBIT__ALPSRT

269136480_Cal_ML_DSk_TC

Figura 11

Para facilitar la exploración de las imágenes, conviene trabajarlas en dB pues resulta más natural a nuestra vista, obteniendo un nuevo producto (Figura 12):

ALOS-H1_1__A-ORBIT__ALPSRT

269136480_Cal_ML_DSk_TC_dB

Figura 12

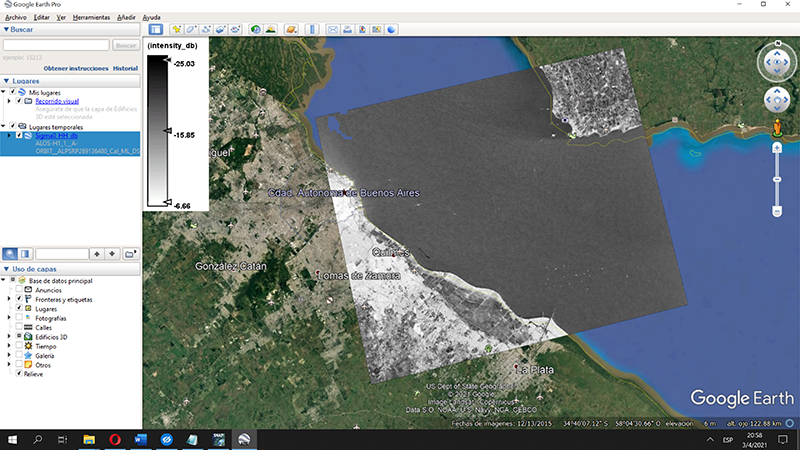

Es posible visualizar nuestra imagen en el Google Earth (Figura 13):

Figura 13

También podemos observar una parte de la imagen para su análisis que, en este caso sería un subset que incluye a Florencio Varela y zonas aledañas (Figura 14):

Figura 14

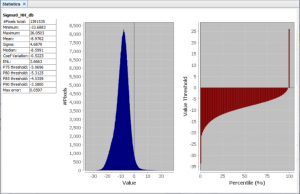

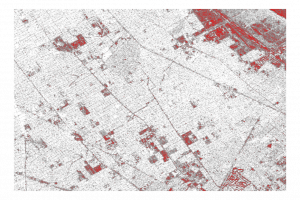

Realizamos un análisis estadístico sobre la zona en cuestión (Figura 15) donde pueden verse en el mapa de reflectividad del suelo, las interacciones con el blanco. La energía reflejada depende de la geometría y la constante dieléctrica del blanco, viéndose más claros los esquemas de alta energía y más oscuros las zonas que devuelven poca energía: las zonas correspondientes a la ciudad devuelven mucha energía mientras que donde está el río o tierra desnuda la señal se absorbe y se pierde. En la figura 16 se reemplazaron los negros (baja interacción) por color rojo.

Figura 15

Figura 16

El próximo análisis corresponde a imágenes tomadas por Sentinel 1. La misión Sentinel 1 es una iniciativa conjunta de la Comisión Europea y la Agencia Espacial Europea. Se compone de dos satélites el Sentinel 1A y el Sentinel 1B que fueron lanzados en los años 2014 y 2016 respectivamente. Estos dos satélites comparten el mismo plano orbital capturando imágenes SAR en banda C. Su longitud de onda de 5 cm hace que sus imágenes no se vean afectadas por las condiciones meteorológicas, el día o la noche. Se pueden capturar datos en cuatro modos de imágenes de diferente resolución, de hasta 5 m y con una cobertura de hasta 400 km de ancho de barrido. Proporciona capacidad de polarización y tiempos de revisita muy cortos, con una resolución temporal de 6 días entre los dos satélites.

El Sentinel 1 es un radar que se caracteriza por una visión lateral, la tecnología del radar de apertura sintética o SAR basado en el efecto Doppler es capaz de generar imágenes y los píxeles representan el coeficiente de retrodispersión de esa área sobre el terreno. Siendo el valor almacenado mayor, mayor será la intensidad de la señal de retorno, a diferencia de la teledetección óptica que mide la radiancia espectral.

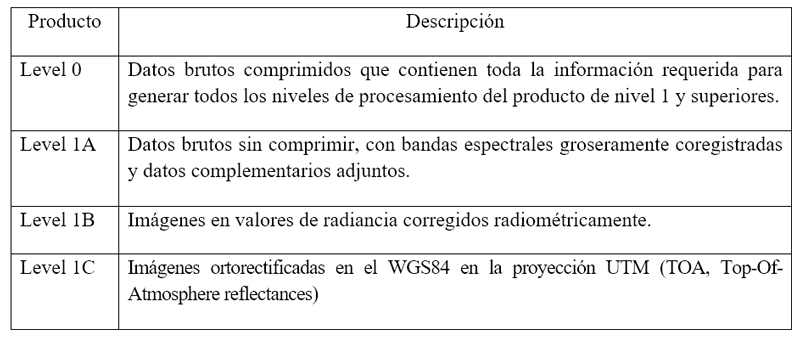

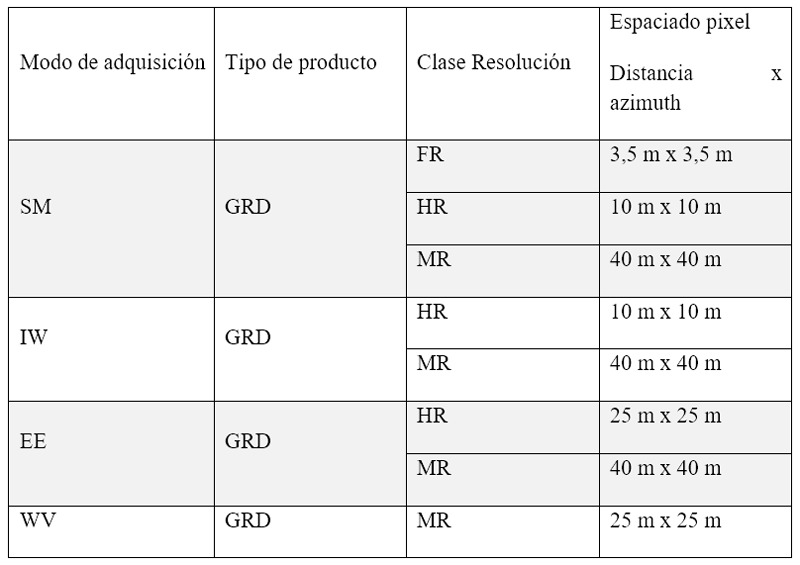

Las imágenes a descargar con diferentes niveles de procesamiento pueden verse en la tabla siguiente:

Los productos que podemos encontrar a su vez se dividen según el tipo de proceso:

- Single Look Complex (L-1 SLC): productos SAR de nivel 1 georreferenciados utilizando datos de la órbita y la altitud del satélite. Comprenden imágenes complejas con amplitud y fase. Su distribución está limitada a áreas específicas relevantes.

- Ground Range Detected (L-1 GRD): productos SAR de nivel 1 que han sido proyectados usando un modelo elipsoidal de La Tierra. Estos productos podemos encontrarlos además con 3 resoluciones: Full Resolution (FR), High Resolution (HR) y Medium Resolution (MR). Traen información de intensidad multi-looked. Su distribución es sistemática.

- Ocean (L-2 OCN): productos oceánicos de nivel 2 con parámetros geofísicos recabados del océano, sobre la velocidad y la dirección del viento. Especialmente diseñados para estudios del océano. Su distribución también es sistemática.

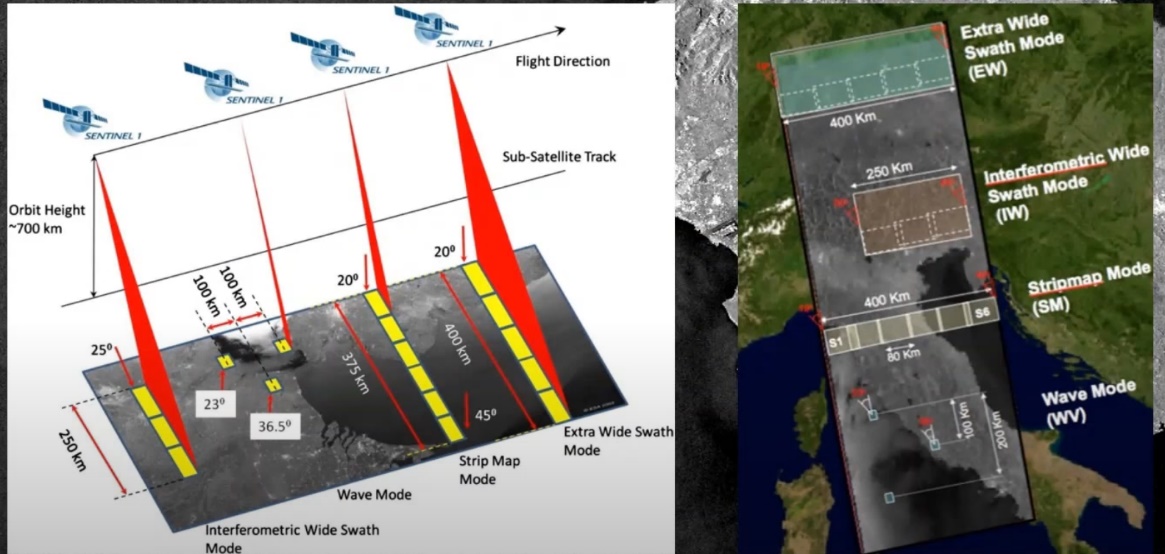

Por otra parte, habrá que tener en cuenta la diferencia entre los modos de adquisición del Sentinel-1 (Ver figura 17):

- Stripmap (SM): que proporcionará datos con una resolución de 5m x 5m y un ancho de escena (swath) máximo de 80km. Solo se usa para estudiar islas pequeñas y bajo petición, o para eventos extraordinarios como la gestión de emergencias.

- Interferometric Wide Swath (IW): este modo combina un ancho de escena de (swath) 250km con una resolución moderada de 5m x 20m. Este es el modo por defecto sobre tierra, con resolución geométrica y radiométrica adecuada para la mayoría de las aplicaciones.

- Extra-Wide Swath (EW): Swath muy grande de 400km con una resolución de 20m x 40m. Este modo se emplea sobre zonas marítimas y polares, donde se necesita una gran cobertura y tiempos de revisita cortos. Se utiliza para vigilancia en amplias zonas de costa en mares europeos, áreas del Ártico y del Océano Austral, en aplicaciones relacionadas con el tráfico marítimo, derrames de petróleo y para la supervisión del hielo marino.

- Wave Mode (WV): este modo se compone de pequeñas escenas de StripMap llamadas viñetas (vignettes) de 20km x 20km con una resolución 5m x 5m que se adquieren alternativamente con dos ángulos de incidencia cada 100km. Se usa principalmente en aplicaciones de monitoreo en aguas abiertas y también pretende ayudar en la determinación de la dirección y altura de olas en el océano.

Figura 17

Además, en estos productos, hay que tener en cuenta la polarización. Los productos en modo WV solo estarán disponibles para polarización simple (VV o HH) y para los demás modos, SM, IW y EW, estarán disponibles en polarización dual (VV+VH o HH+HV) o simple.

En la siguiente tabla vemos los distintos tipos de productos y niveles de procesamiento Sentinel-1 distribuidos por la ESA, que incluyen:

Los productos están a disposición con polarización única para el modo de adquisición Wave y doble polarización o polarización única para los otros tres modos de adquisición.

Para este trabajo utilizamos un producto Level 1 GRD (Ground Range Detected) que contiene datos SAR proyectados utilizando un modelo elipsoidal WG84, que incluye el valor de la amplitud, pero que pierde la información de la fase.

Disponible en varias resoluciones en función del modo de adquisición (SM, IW, EW, WY) y por el nivel de procesamiento multilooking empleado como figura en la tabla.

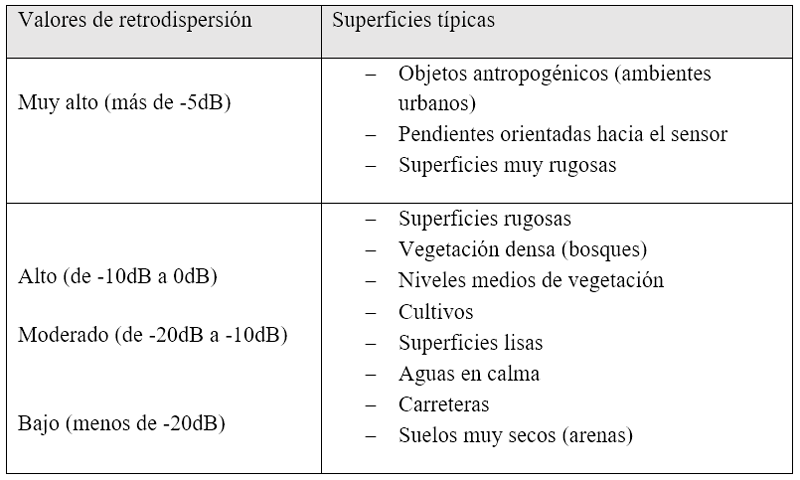

Cada pixel de la imagen se corresponde con el coeficiente de retrodispersión, siendo más alto el valor cuanto más alta es la intensidad de la señal de retorno. El ángulo de incidencia es el ángulo entre la iluminación del radar y la vertical de la superficie del radar. Los ángulos pequeños tienen una mayor retrodispersión, en general, las pendientes hacia el radar, tienen una alta retrodispersión y aparecen brillantes. Vemos valores típicos de retrodispersión en la siguiente tabla:

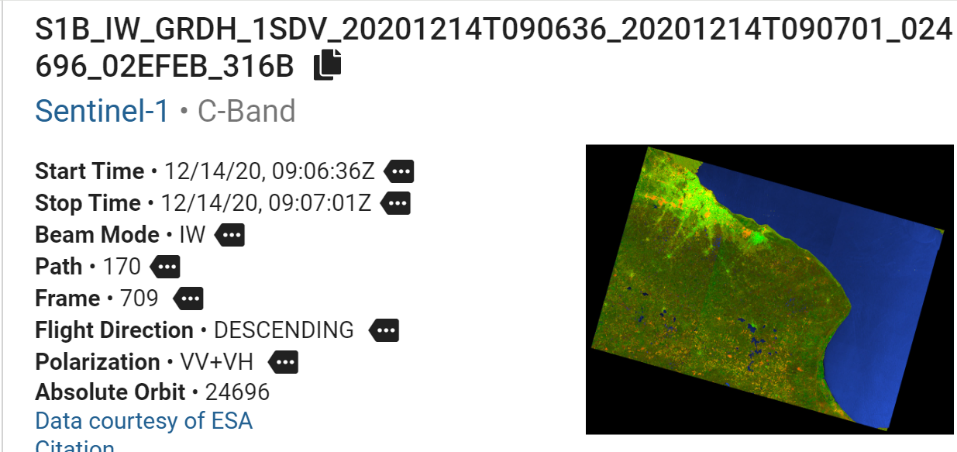

Veamos ahora la nomenclatura de los productos Sentinel-1 GRD.

La imagen que bajamos tiene el siguiente nombre:

S1B_IW_GRDH_1SDV_20201214T090636_20201214Y090701_024696_02EFEB_316B

S1B: corresponde al satélite (S1A ó S1B)

IW: Modo de adquisición (SM, IW, EW, WV)

GRDH: Tipo de producto (SLC, GRD, OCN) y resolución en GRD (F, H, M)

1SDV: Nivel de producto (1.2), clase (S, A) y polarización (SH, SV, DH, DV)

20201214T090636_20201214Y090701: Fecha de adquisición (inicio_final). Formato de fecha

YYYMMDDTHHMMSS

024696 número de órbita absoluta

02EFEB: data take

316B: Identificador único del producto

Entonces, esta es nuestra imagen:

S1B_IW_GRDH_1SDV_20201214T090636_20201214Y090701_024696_02EFEB_316B

Para interpretar mejor la imagen, se le hace un flujo de tratamientos que imprimen a la región correcciones estandarizadas, vemos la primera imagen tal cual la bajamos (Figura18):

Figura 18

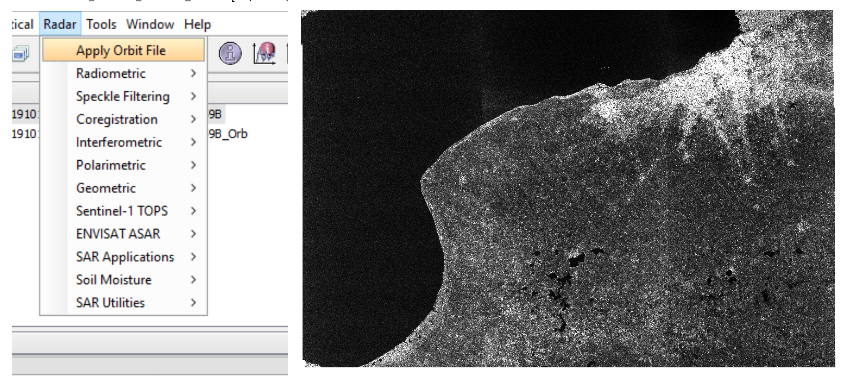

Lo primero que puede verse en el programa SNAP es que la imagen no está georeferenciada. Los metadatos de la imagen suelen no ser muy precisos, las órbitas precisas se calculan a posteriori, la descarga automática de esta información provee a la imagen de una información más rigurosa. Tras aplicar la órbita, se agregó el sufijo Orb al nombre de la imagen y obtenemos la siguiente imagen (Figura 19):

S1B_IW_GRDH_1SDV_20201214T090636_20201214Y090701_024696_02EFEB_316B_Orb

Figura 19

Las imágenes de intensidad de brillo radar, se distribuyen afectadas por ruido térmico, lo que afecta a la polarización cruzada. Aplicamos la corrección y obtenemos un nuevo producto (Figura 20):

S1B_IW_GRDH_1SDV_20201214T090636_20201214Y090701_024696_02EFEB_316B_Orb_TNR

Figura 20

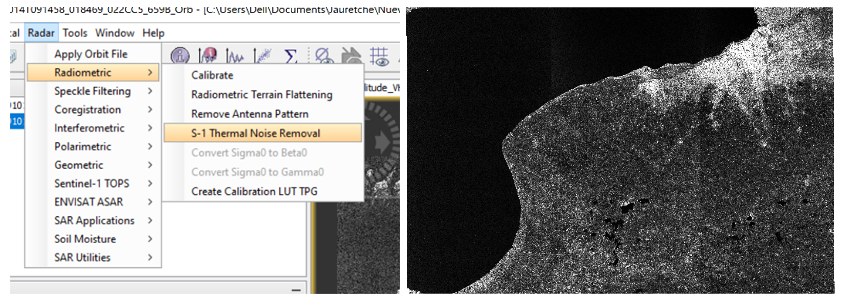

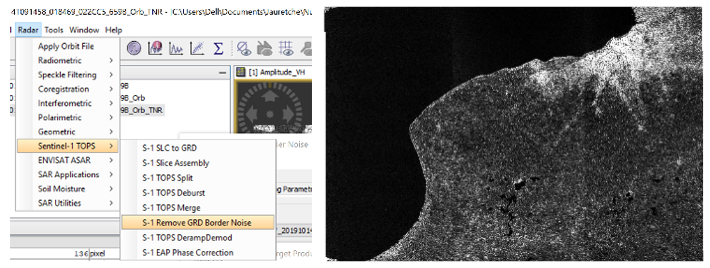

A veces, aparecen artefactos radiométricos en el borde de la imagen, por lo cual aplicamos una nueva herramienta que corrige los bordes para Sentinel-1 Remove GRD Border Noise, obteniendo un nuevo producto (Figura 21):

S1B_IW_GRDH_1SDV_20201214T090636_20201214Y090701_024696_02EFEB_316B_Orb_TNR_Bdr

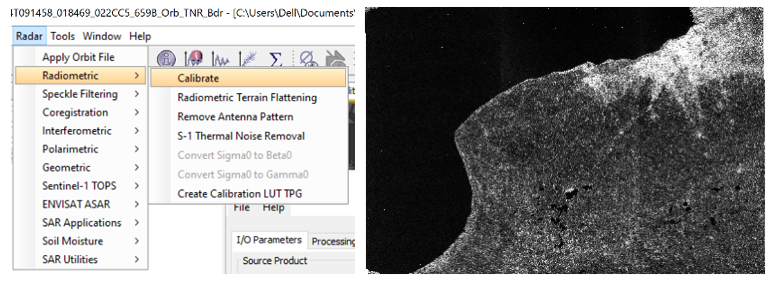

Figura 21

El próximo paso es la calibración de la imagen, la cual convierte los niveles digitales de la imagen en valores radiométricamente calibrados de retrodispersión. La información necesaria para este procesamiento viene incluida en los metadatos de la imagen. El valor de la retrodispersión está relacionado con el ángulo de incidencia, la longitud de onda, la polarización y las propiedades reflectivas de las cubiertas que son observadas. El nuevo producto obtenido es (Figura 22):

S1B_IW_GRDH_1SDV_20201214T090636_20201214Y090701_024696_02EFEB_316B_Orb_TNR_Bdr_Cal

Figura 22

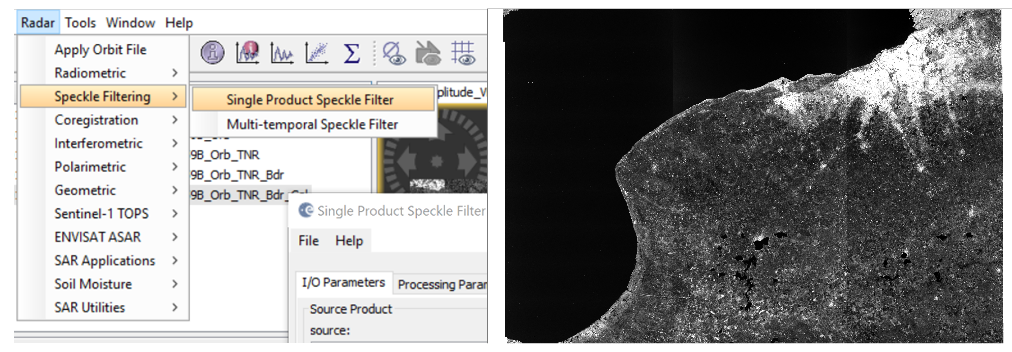

Veremos ahora de aplicar una corrección para el ruido Speckle, que aparece en las imágenes de radar a modo de sal y pimienta, y se debe a las interferencias de las ondas que son reflejadas en la dirección del satélite, desde varios tipos de cubiertas con comportamientos reflectivos diferentes. Aplicaremos el filtro de Lee sigma, que es un filtro con el que se obtienen muy buenos resultados, el programa SNAP, tiene varios filtros distintos para seleccionar. Obteniendo así un nuevo producto de la figura 23:

S1B_IW_GRDH_1SDV_20201214T090636_20201214Y090701_024696_02EFEB_316B_Orb_TNR_Bdr_Cal_Spk

Figura 23

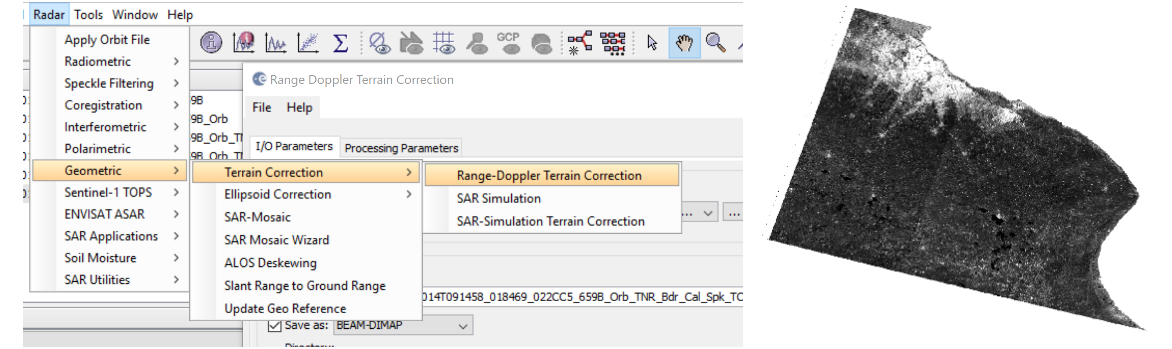

Lo siguiente es hacer la corrección geométrica de la imagen, por la configuración y el modo en que son captadas las imágenes del radar, se producen algunas distorsiones geométricas, con esta corrección la imagen se va a parecer lo máximo posible al mundo real. Las distorsiones son provocadas por los efectos de la topografía y de la sombra y se corrigen empleando un modelo digital de elevación. Obtenemos, entonces un nuevo producto (Figura 24):

S1B_IW_GRDH_1SDV_20201214T090636_20201214Y090701_024696_02EFEB_316B_Orb_TNR_Bdr_Cal_Spk_TC

Figura 24

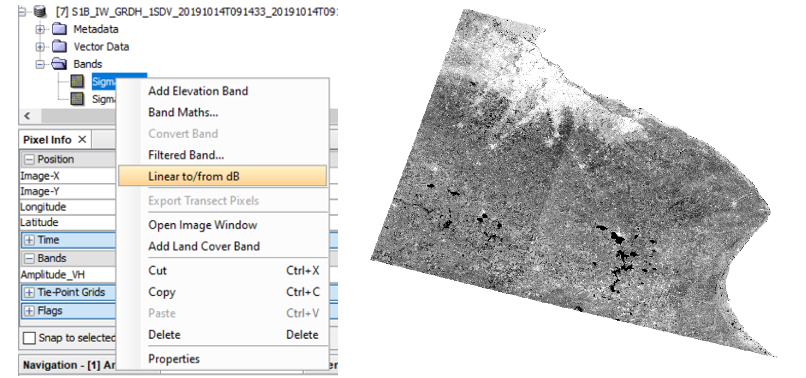

Por último, convertimos los valores de retrodispersión en dB en las dos polarizaciones, obteniendo dos nuevas bandas virtuales (Figura 25).

Figura 25

Observamos el producto final obtenido y tiene gran diferencia con el producto descargado al principio. Aquí ya podemos aplicar nuevos algoritmos para observar lo que queríamos estudiar.

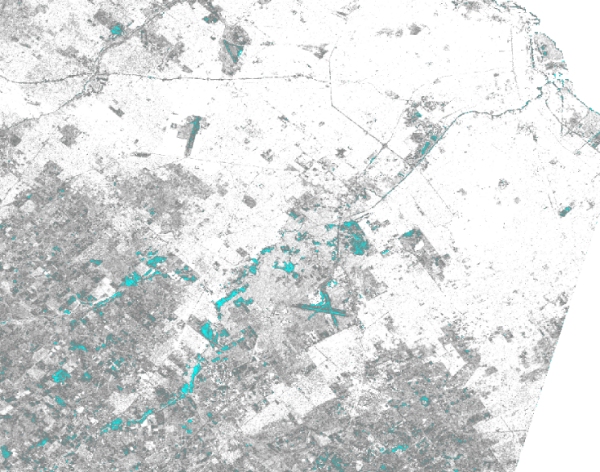

La siguiente imagen corresponde al 14 de octubre del año 2019, el día 12 de octubre hubo una gran cantidad de lluvia caída, y dos días después, aún pueden verse los remantes de agua en color celeste (Figura 26). Este procesamiento se realizó a la imagen del satélite Sentinel-1:

S1B_IW_GRDH_1SDV_20191014T091433_20191014T091458_018469_022CC5_659B

Se trabajó con la herramienta de manipulación de color sobre el histograma, obteniendo la figura 26 donde puede verse el arroyo con gran cantidad de agua claramente.

Figura 26

Recomendaciones o Discusión

El trabajo sobre las imágenes de radar es bastante complejo. La puesta a punto de la imagen para su posterior tratamiento con distintos algoritmos es un proceso laborioso, la comprensión de cada transformación de la imagen, no resulta para nada sencilla, siempre se deben buscar fundamentos teóricos y mucho razonamiento. De todas maneras, se llegó a obtener productos a los cuales se pueden aplicar los algoritmos de segmentación para encontrar las inundaciones, incluso conseguimos ver los efectos, pero solo en una imagen. De todas formas, debería haberse relevado el campo para validar los resultados.

El problema radica en la dificultad de obtener las imágenes de alta resolución y con la polarización deseada para fechas específicas, antes de la lluvia y después de la lluvia en nuestro caso. El hecho de que ahora se disponga de las imágenes de SAOCOM es una buena noticia, porque son satélites que están orientados a recabar imágenes de nuestro país, y en abundante cantidad.

La obtención de resultados originales relativos al procesamiento de imágenes satelitales, tema en el que se centra este proyecto, puede dar lugar a la preparación de textos académicos para su posterior publicación o presentaciones en congresos. Eventualmente algunos de los resultados podrían ser patentables y/o transferidos como servicios a instituciones públicas y empresas privadas para que dispongan de ellos.

El desarrollo del clúster con la demora en el inicio y luego la pandemia, quedó relegado, porque las pruebas se hicieron sobre la conexión de varias PC y se necesitaba de la presencia de los integrantes del equipo. El desarrollo del clúster puede acortar los tiempos de procesamiento, por lo cual sería muy importante continuar con su desarrollo, y puede ser utilizado no solo para este proyecto, sino para otros que necesiten gran capacidad de procesamiento.

El Desarrollo de recursos humanos en esta línea de investigación puede dar lugar a la producción de Tesinas de finalización de carrera, de tesis de Maestría y de Doctorado.

Conclusiones

El trabajo resultó muy bueno como introducción al tema, pero falta camino por recorrer, el hecho de haber encontrado una imagen luego de una inundación hizo que se pudiera probar un algoritmo de segmentación. Para un próximo período es esperable obtener mayores resultados en cuanto a la prueba con distintos algoritmos.

Referencias bibliográficas

- Chuvieco Salinero, Emilio. 1996. Fundamentos de Teledetección Espacial (3ª Edición Revisada). Rialp, Madrid. ISBN: 84-321-3127-X.

- Chuvieco Salinero, Emilio. 2002. Teledetección Ambiental: La observación de la Tierra desde el Espacio. Ed. Ariel, Barcelona. ISBN: 84-3448-047-6.

- Italian Space Agency, 2009. Cosmo SkyMed SAR Products Handbook.

- Crosta, Álvaro Penteado. 1999. Processamento Digital de Imagens de Sensoriamento Remoto (Edição Revisada – 3ª Reimpressão). IG/UniCamp, Campinas. ISBN: 85-8536-902-7.

- Gonzalez, Rafael; Woods, Richard. 2008 Digital Image Processing, Pearson Prentice Hall. ISBN 0-13-168728-x 978-0-13-168728-8

- Jensen, John R. 2009. Sensoriamento Remoto do Ambiente: Uma Perspectiva em Recursos Terrestres (Tradução da 2ª Edição). Parêntese, São José dos Campos. ISBN: 978-85-60507-06-1.

- Oliver, Chris y Quegan Shoun Understanding Synthetic Aperture Radar Images. 2004 .Scitech Puyblishing Inc. ISBN 1-891121-31-6

- Sabins, Floyd F. 1997. Remote Sensing Laboratory Manual (Revised 3rd Edition). Kendall/Hunt Publishing Co, Dubuque. ISBN: 0-7872-2543-6.

- Sabins, Floyd F. 2000. Remote Sensing: Principles and Interpretation (3rd Edition – 3rd Printing). H. Freeman & Co, New York. ISBN: 0-7167-2442-1

- Ulaby, Fawwaz; Moore, Richard; Fung, Adrian. 1981. Microwave Remote Sensing Active and Passive. Volume 1. Addisson-Esley Publishing Company, Canadá. ISBN 0-201-10759-7 (v.1.)

- Curso de procesamiento de imágenes Sentinel con SNAP del Instituto Geográfico Nacional de España

- Curso Introducción a la detección SAR de la Unidad de Educación y Formación Masiva de la Misión SAOCOM – CONAE

- ESA/CONAE C/L/X band SAR Training Course

Notas

[1] aliciaszy@yahoo.com.ar